GPT-4 ha llegado para revolucionar Internet una vez más. Esta nueva versión del ya famoso modelo de lenguaje no solo puede entender texto, ¡sino también imágenes! Hoy entenderemos qué tecnología hay detrás de este sistema, y cómo su anuncio ha sacudido las estrategias comerciales de todo el panorama tecnológico.

El mundo sigue patas arriba tras la publicación de Chat-GPT, y con sobrados motivos. El abanico de tareas que parece ser capaz de resolver sigue ampliándose, casi siempre con resultados exitosos. Y es que la empresa desarrolladora, OpenAI, continúa mejorando sus modelos casi a diario. Esta semana desvelaba su último producto basado en Inteligencia Artificial: GPT-4, un “modelo basado en Transformers entrenado para predecir el siguiente token en un documento”[1]. Pero, ¿qué significa eso?

Cualquier ser vivo es, empleando terminología propia del campo de la IA, un sistema multimodal: nuestra percepción no se limita tan sólo a la visión, al oído o al lenguaje, sino que constantemente integramos esas fuentes de información en un único canal que conforma nuestra experiencia. Esta capacidad de hacer converger diferentes fuentes de datos nos ayuda a entender de una manera más robusta el mundo que nos rodea[2] Sin embargo, algo consustancial a nosotros ha sido tradicionalmente un cuello de botella en el desarrollo de modelos IA más complejos. Los algoritmos inteligentes eran shallow AI, se decía, porque sólo eran capaces de aprender patrones contenidos en los datos siempre que éstos pertenezcan a una tarea muy concreta, y no eran capaces de extrapolar lo aprendido a partir de lenguaje natural a problemas relacionados con la visión.

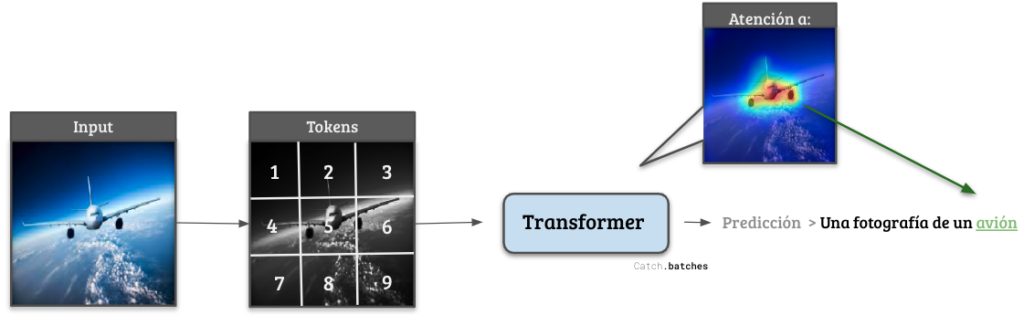

Esto comenzó a cambiar en verano de 2017. En un artículo publicado por investigadores de Google Brain titulado en español “Un Modelo para Dominarlos A Todos” los autores propusieron un sistema de IA unificado que era capaz de realizar tareas relacionadas tanto con problemas de lenguaje como con la clasificación visual de imágenes[3]. Más importante, descubrieron que el entrenamiento conjunto en textos e imágenes mejoraba el rendimiento posterior del sistema en todas las pruebas de evaluación. Así, el modelo estaba mejorando su comprensión del término “perro” no sólo por ver esa palabra en muchos textos escritos diferentes, sino también en base a ser expuesto a miles de imágenes mostrando perros. Esto sucedía porque al tokenizar ambos tipos de datos (texto e imágenes), el modelo de IA no vieía directamente ni palabras ni píxeles, sino un número (un token) representando una palabra concreta o una región de la imagen. Así, tras entrenarse en millones de ejemplos, el sistema aprendía que los tokens correspondientes a la palabra “perro” y a su representación visual debían tener un significado similar, aunque fuera en modalidades diferentes. Dicho de otra forma, la representación que el modelo tenía de un perro era ahora más general y robusta que antes.

Figura 1: Diagrama de cómo funciona un sistema de clasificación de imágenes basado en Transformers. Su gran ventaja radica en la capacidad de ser selectivo con diferentes regiones de los datos de entrada.

En diciembre de ese mismo año, el mismo equipo de investigadores publicó otro artículo llamado “Atención es todo lo que necesitas”, que en menos de 5 años acumula más de 68.000 citas[4]. En él, los autores introdujeron una clase novedosa de neuronas artificiales, las cuales bautizaron como Transformers. La característica más reseñable de este tipo de neuronas es capacidad de prestar atención a zonas específicas del input, permitiéndoles enfocar su procesamiento únicamente en las partes del texto, la imagen o el audio más relevantes para el éxito de la tarea, como se aprecia para un ejemplo en la Figura 1. Son estos Transformer, junto con la codificación de textos e imágenes mediante tokens, los actuales pilares que soportan toda una nueva generación de modelos de IA: Chat-GPT, DALL-E2[5], Whisper[6]… Y ahora, GPT-4.

Según lo indicado por OpenAI, esta versión del potente modelo de lenguaje sería capaz de procesar desde fotos realistas hasta diagramas y esquemas de la misma manera que procesa un texto normal, algo inaudito hasta ahora. La compañía no ha comunicado ningún aspecto técnico, marcando así un punto de inflexión con respecto a la mentalidad de código libre o abierto imperante entre la comunidad tecnológica. Desde su fundación, corporaciones como Google, Facebook o Amazon apostaron por potentes equipos de investigación procedentes de las mejores universidades del mundo para desarrollar nuevas vías de negocio. Como aliciente para estos profesionales, sus ideas eran luego publicadas en forma de artículos científicos. Esta estrategia les permitió posicionarse como una cara amable con el usuario, permitiendo señalar aspectos a mejorar, o desarrollar sus propias herramientas a partir de dicho código abierto, aceptando el riesgo de que sus competidores usaran luego los frutos de su trabajo gratis.

Y es que en efecto, OpenAI, empresa cofundada por Elon Musk en 2015, no ha dudado en aprovechar al máximo las ideas presentadas en los artículos que comentábamos antes para convertirse en un auténtico gigante y posicionarse como una empresa líder en el sector. De hecho, se amparan en la feroz competencia existente en el mercado o en posibles malos usos para explicar su silencio a nivel técnico. Han llegado incluso a afirmar que “[Google] se equivoca […]. Si crees que la IA va a ser extremada e increíblemente potente, y que puede emplearse con malos fines, entonces no tiene sentido que sea de acceso abierto. Es una mala idea…” en palabras de un ex-empleado de Google ahora en OpenAI. En última instancia, puede que la estrategia de código abierto de Google haya sido “demasiado” idealista, y que el futuro de la IA haya comenzado a tener un dueño.

Las implicaciones que tendrá este cambio de estrategia comercial no son evidentes todavía. ¿Comenzarán otras compañías a proteger celosamente su propiedad intelectual? Es indudable que gran parte del éxito y rápida adopción de herramientas basadas en IA se debe a la política de código abierto auspiciada hasta ahora por estas empresas. Sencillamente, cualquier individuo con unos conocimientos básicos de programación podía probar en cuestión de minutos sus propias ideas utilizando para ello la tecnología más avanzada. Si las IAs se convierten en otro producto SaaS (Software-As-A-Service) cuyas especificaciones queden fuertemente blindadas y en secreto, es posible que estemos condenados a que sólo los agentes con mayor capacidad financiera puedan tener acceso al desarrollo de tecnología avanzada. Y eso, en un mundo cada vez más controlado y monitorizado por algoritmos inteligentes, es algo que debiera preocuparnos.

Referencias

[1]: OpenAI, 2023. GPT-4 Technical Report. https://doi.org/10.48550/arXiv.2303.08774

[2]: Man, K., Kaplan, J.T., Damasio, A., Meyer, K., 2012. Sight and Sound Converge to Form Modality-Invariant Representations in Temporoparietal Cortex. J. Neurosci. 32, 16629–16636. https://doi.org/10.1523/JNEUROSCI.2342-12.2012

[3]: Kaiser, L., Gomez, A.N., Shazeer, N., Vaswani, A., Parmar, N., Jones, L., Uszkoreit, J., 2017. One Model To Learn Them All. https://doi.org/10.1007/s11263-015-0816-y

[4]: Vaswani, A., Shazeer, N., Parmar, N., Uszkoreit, J., Jones, L., Gomez, A.N., Kaiser, Ł., Polosukhin, I., 2017. Attention Is All You Need. Advances in Neural Information Processing Systems 2017-December, 5999–6009. https://doi.org/10.48550/arxiv.1706.03762

[5]: Ramesh, A., Dhariwal, P., Nichol, A., Chu, C., Chen, M., 2022. Hierarchical Text-Conditional Image Generation with CLIP Latents. https://doi.org/10.48550/arxiv.2204.06125

[6]: Radford, A., Kim, J.W., Xu, T., Brockman, G., McLeavey, C., Sutskever, I., 2022. Robust Speech Recognition via Large-Scale Weak Supervision. https://doi.org/10.48550/arXiv.2212.04356